Hoe Model Context Protocol de integratie voor AI-applicaties kan automatiseren (en je uren codeerwerk kan besparen)

Voor elke externe tool die je met je AI-systeem wilt verbinden, moet je een custom integratie bouwen. Dat brengt twee grote nadelen met zich mee. Eén: het kost veel tijd. Twee: deze manier van werken is niet schaalbaar. Gelukkig kan het Model Context Protocol (MCP) dit oplossen. In dit artikel leggen we uit hoe MCP werkt, wat er aan de serverzijde gebeurt en gaan we in op security.

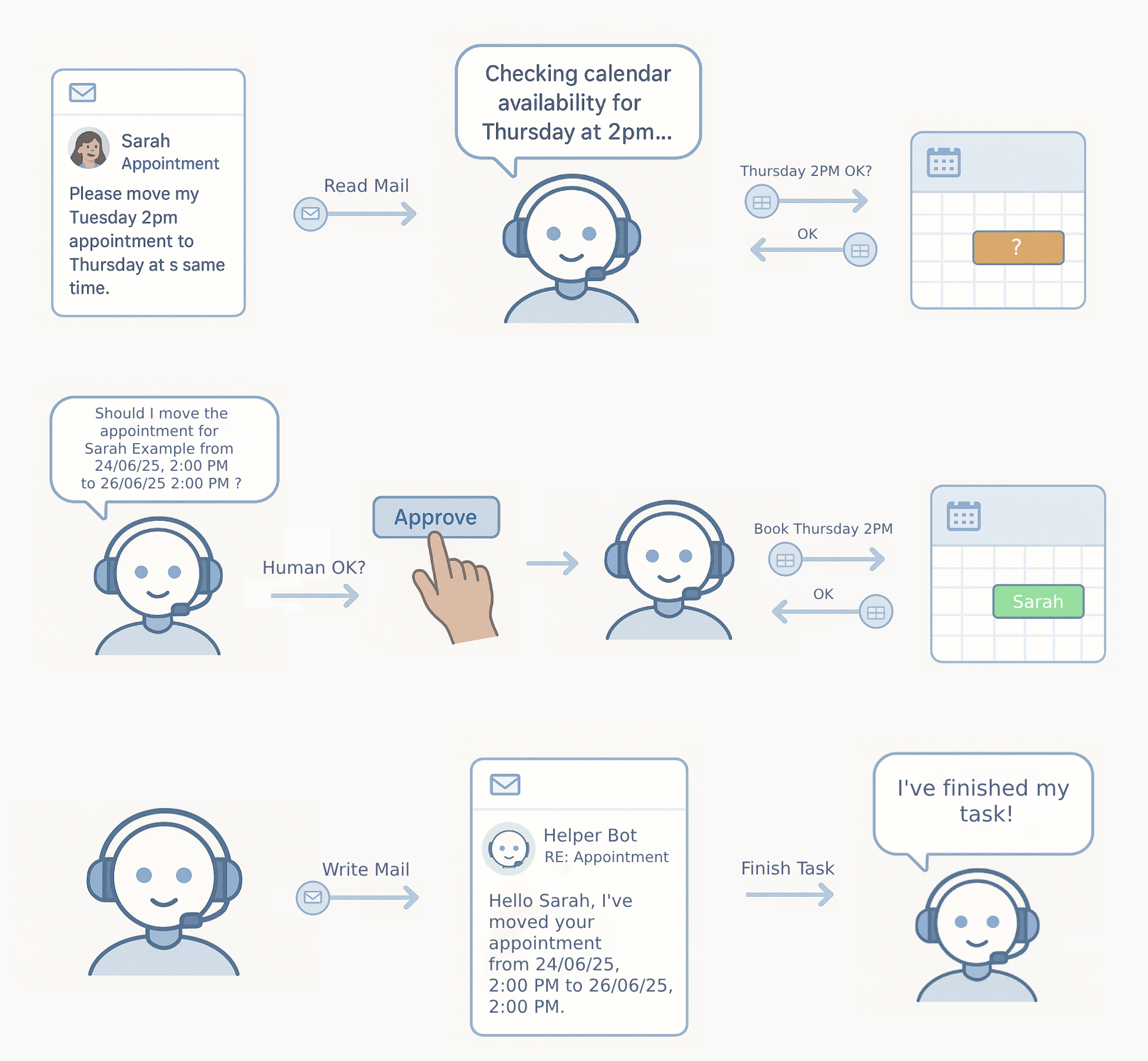

Stel je voor dat je een afspraakplanningsapplicatie wilt ontwikkelen voor een medische praktijk. Je doel is een AI-assistent te maken die afspraken beheert via e-mail.

Laten we kijken naar een van de verzoeken die die assistent kan ontvangen.

Een patiënt genaamd Sarah schrijft: “Hi, ik moet mijn afspraak van dinsdag om 14.00 uur verplaatsen naar donderdag op hetzelfde tijdstip.”

Laten we de verschillende stappen bekijken die nodig zijn om dit verzoek uit te voeren.

De workflow

Dit gebeurt er:

- Je AI leest de e-mail.

- Ze controleert de agenda van de arts en ziet dat donderdag om 14.00 uur beschikbaar is.

- De AI-assistent vraagt goedkeuring aan de medisch receptioniste: “Zal ik Sarah’s afspraak van dinsdag 14.00 uur verplaatsen naar donderdag 14.00 uur?”

- Na goedkeuring werkt het systeem de agenda bij.

- Tot slot stuurt de AI een e-mail naar de patiënt om de nieuwe afspraak te bevestigen.

De verschillende stappen bij het verplaatsen van een afspraak.

De verschillende stappen bij het verplaatsen van een afspraak.

Deze workflow vereist dat je AI:

- e-mails leest,

- agendagegevens raadpleegt,

- afspraken wijzigt,

- e-mails verstuurt.

Elk van deze taken is gekoppeld aan verschillende systemen met verschillende API’s.

Het integratieprobleem: een schaal- en onderhoudsnachtmerrie

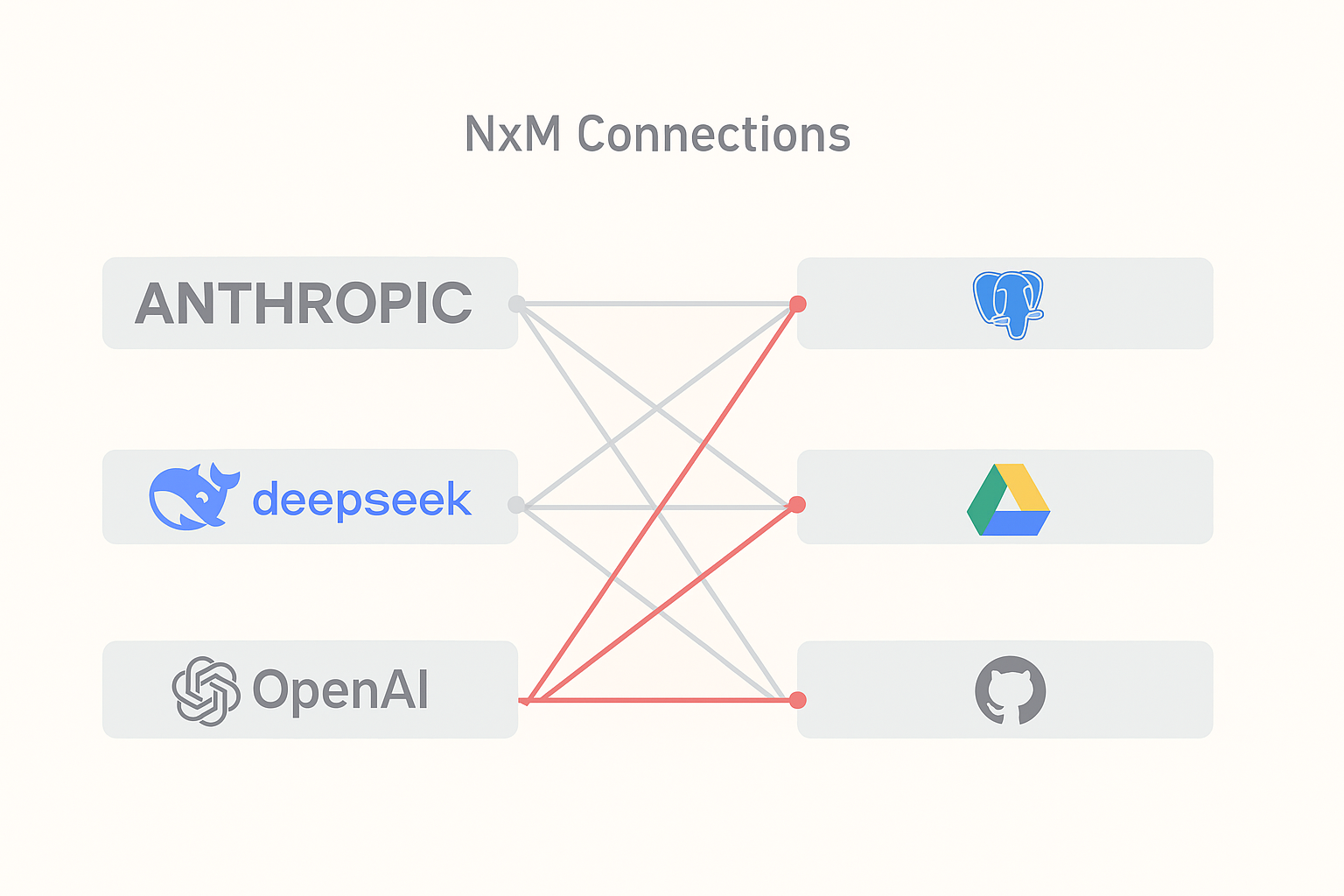

Tot voor kort betekende het verbinden van AI-systemen met externe tools dat je voor elke mogelijke combinatie custom integraties moest bouwen. Een aanpak die niet schaalbaar is.

Waarom niet?

Omdat het huidige landschap een klassieke schaalnachtmerrie is. AI-systemen zoals Claude, GPT-4 en Gemini moeten verbinding maken met duizenden verschillende tooldatabases, API’s, bestandssystemen, cloudservices, het custom inventarissysteem van je neef… noem maar op.

Voor elke taak die je AI-applicatie moet uitvoeren, moet je een custom integratie opzetten.

Zonder standaardprotocol heeft elk AI-systeem custom code nodig om met al die verschillende tools te communiceren. Wil je dat Claude Google Drive-bestanden leest? Dat is één integratie. Wil je ook Slack-berichten laten controleren? Dat is een volledig aparte integratie.

Vermenigvuldig dit over tientallen taken en honderden tools, en je moet duizenden individuele connecties onderhouden.

Dit N×M-schaalprobleem is ook een onderhoudsnachtmerrie. Want elke integratie vereist:

- aparte documentatie,

- authenticatie-afhandeling,

- foutbeheer,

- doorlopend onderhoud, aangezien API’s onvermijdelijk veranderen.

We hebben teams meer tijd zien besteden aan het onderhouden van integraties dan aan het bouwen van echte features.

De integratiechaos oplossen: het Model Context Protocol

Het Model Context Protocol (MCP) verandert dit. Het biedt een gestandaardiseerde manier voor AI-systemen om te communiceren met externe tools en services. MCP pakt de integratiechaos aan door een universele communicatielaag te creëren.

Hoe werkt MCP?

MCP introduceert een gestandaardiseerde communicatielaag tussen AI-systemen (clients) en externe tools (servers). In plaats van N×M-integraties bouw je N+M: elk AI-systeem implementeert één keer MCP, en elke tool biedt één keer een MCP-interface aan.

Alleen al de rekensom zou je blij moeten maken.

Het protocol gebruikt JSON-RPC 2.0 voor de berichtopmaak, wat gestructureerde request-responsecommunicatie mogelijk maakt. Als je eerder met API’s hebt gewerkt, voelt dit vertrouwd aan:

Model Context Protocol ondersteunt twee transportmechanismen:

- stdio voor lokale ontwikkeling (waarbij de client de server als subprocess start)

- HTTP met Server-Sent Events (SSE) voor remote deployments.

Wil je gevoel krijgen bij het schrijven en gebruiken van MCP-servers, begin dan met stdio, dat is eenvoudiger te debuggen.

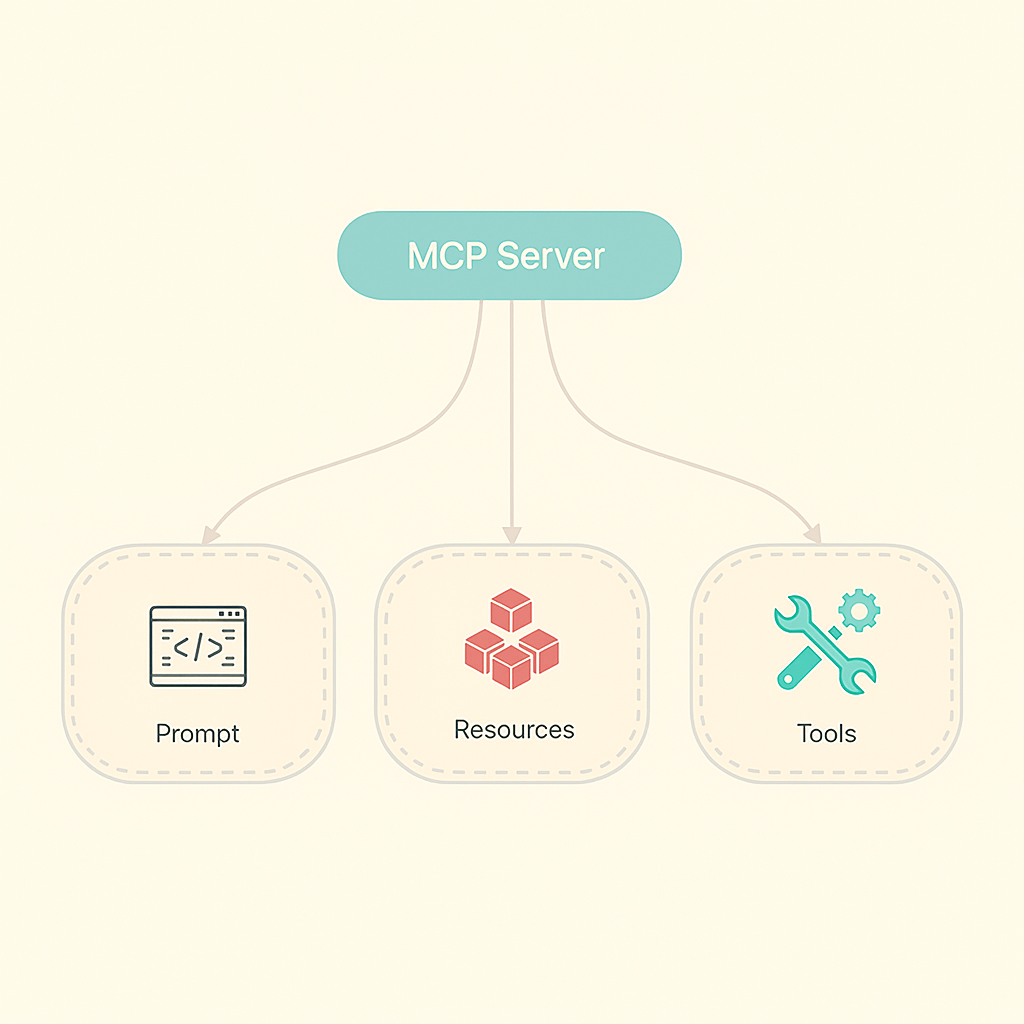

Wat servers daadwerkelijk aanbieden

Model Context Protocol-servers bieden drie soorten functionaliteiten aan. Het onderscheid begrijpen is belangrijk voor hoe je je integraties ontwerpt.

De drie soorten functionaliteiten die een MCP-server aanbiedt.

De drie soorten functionaliteiten die een MCP-server aanbiedt.

1. Prompts

Prompts zijn templates die helpen om AI-interacties te structureren. Zoals “analyseer dit errorlog volgens dit specifieke format” of “vat dit document samen met focus op security-issues”.

Het is op dit moment waarschijnlijk de minst gebruikte mogelijkheid, maar het is handig om te standaardiseren hoe je AI’s specifieke taken laat uitvoeren.

2. Resources

Resources bieden read-only toegang tot data zoals configuratiebestanden, logs of documentatie. Deze operaties hebben geen neveneffecten, ze zijn puur informatief. Perfect voor zaken als “toon de huidige systeemstatus” of “wat staat er in dit logbestand?”

3. Tools

Tools zijn de echte werkpaarden. Dit zijn functies die daadwerkelijk acties uitvoeren zoals schrijven naar databases, e-mails versturen of bestanden wijzigen. Deze operaties hebben neveneffecten en vereisen zorgvuldig permissiebeheer.

Hier wordt het interessant, maar moet je ook goed nadenken over security.

Client Security: creëer een sandbox

Hier wordt Model Context Protocol serieus in het voorkomen dat je AI per ongeluk je volledige database verwijdert. De client fungeert zowel als interface van het AI-systeem als als je securitygrens. Wanneer servers acties willen uitvoeren, moeten ze via specifieke mechanismen toestemming vragen.

De meest kritieke is het roots-systeem, waarbij je definieert tot welke resources servers toegang hebben:

Dit creëert een sandbox: de server kan alleen bestanden binnen die directories benaderen. Maar hier zit de kanttekening: dit is een coöperatief securitymodel. Goed opgevoede servers respecteren deze grenzen. Kwaadaardige niet. Behandel elke MCP-server dus zoals je third-party code zou behandelen.

Servers kunnen ook sampling aanvragen (de AI vragen ergens over te redeneren) en elicitation (aanvullende informatie bij jou opvragen). Deze mechanismen maken multi-step workflows mogelijk terwijl mensen in de loop blijven. Dat is precies wat je wilt voor alles wat ertoe doet, althans voorlopig.

Performance realiteit: hoe vermijd je de bottleneck

Er is een performance-afweging om rekening mee te houden: de RPC-gebaseerde architectuur van MCP introduceert latency ten opzichte van directe functieaanroepen. Elke toolinteractie vereist serialisatie, netwerkcommunicatie en deserialisatie. Voor applicaties die honderden toolcalls per seconde doen, zal deze overhead pijn doen.

We hebben dit zien uitgroeien tot een echte bottleneck in high-throughput omgevingen. Als je iets bouwt dat enorme aantallen snelle toolcalls moet uitvoeren, kan je overwegen om operaties te batchen of bepaalde kritieke functies als directe integraties te behouden.

De stateful aard van het protocol beïnvloedt ook contextmanagement. Multi-step gesprekken met servers verbruiken meer tokens naarmate de context groeit, wat rechtstreeks impact heeft op je kosten als je token-gebaseerde AI-systemen gebruikt. Houd dit in de gaten. Context groeit sneller dan je denkt.

Security-implicaties: validatie en goedkeuring

Model Context Protocol elimineert geen securityproblemen, het standaardiseert ze. Dat is zowel goed als slecht. Prompt injection blijft een reële dreiging; kwaadaardige servers kunnen responses terugsturen met verborgen instructies die AI-systemen misleiden om onbedoelde acties uit te voeren.

Ons advies: behandel elke MCP-server als potentieel onbetrouwbaar. Het roots-mechanisme biedt één beschermingslaag, maar je hebt aanvullende validatie van serverresponses nodig en duidelijke goedkeuringsworkflows voor gevoelige operaties. Het human-in-the-loop-patroon is niet zomaar een nice-to-have, het is je beste verdediging wanneer dingen uit de hand dreigen te lopen.

Terug naar onze afspraakplannings-AI-assistent

aten we die theorie toepassen op ons scenario van de medische praktijk.

We hebben een MCP-server gebouwd die afspraakbeheer-tools en agendaresources aanbiedt. De AI-client maakt verbinding met deze server en krijgt toegang tot planningsfuncties.

Om de verplaatsingsmail naar patiënt Sarah te versturen, volgt de AI een duidelijke workflow. De AI-assistent:

- Ontdekt beschikbare tools (modify_appointment, cancel_appointment, enz.)

- Leest agendaresources om beschikbaarheid te controleren

- Stelt de afspraakwijziging voor aan de menselijke receptioniste

- Voert de wijziging uit na goedkeuring

- Stuurt een bevestigingsmail naar de patiënt

Die menselijke goedkeuringsstap is cruciaal. Ze transformeert de AI van een autonome agent naar een slimme assistent die altijd toestemming vraagt voordat hij handelt. Dit is het patroon dat het best geschikt is voor de meeste real-world applicaties.

Zelf aan de slag: tijd om te experimenteren

Voor lokale ontwikkeling start je met het stdio-transport:

Dit geeft je een werkende MCP-server om mee te experimenteren. Speel ermee! De beste manier om MCP te begrijpen is iets eenvoudigs te bouwen en te ervaren hoe het aanvoelt.

Voor productie-deployments kies je voor HTTP+SSE-transport voor remote servers. Bekijk de officiële documentatie op https://modelcontextprotocol.io voor de volledige specificatie en zoek op GitHub naar “mcp-server” om te zien wat andere developers bouwen.

Conclusie: een onvermijdelijke verschuiving

MCP vertegenwoordigt een onvermijdelijke verschuiving naar gestandaardiseerde AI-integratie. In plaats van dat elke applicatie in isolatie custom AI-features bouwt, bewegen we naar ecosystemen waarin AI-capaciteiten gedeeld en gecombineerd kunnen worden.

Voor developers betekent dit dat je vroeg in je designproces moet nadenken over Model Context Protocol-compatibiliteit. Voor bedrijven betekent het dat je applicaties kunnen deelnemen aan het AI-ecosysteem in plaats van erdoor omzeild te worden. De bedrijven die dit vroeg begrijpen, hebben een significant voordeel.

Het protocol is niet perfect, omdat het performance-overhead introduceert en zorgvuldige security-overwegingen vereist. Maar het biedt een solide basis om AI-integraties te bouwen die over verschillende systemen werken zonder telkens opnieuw te moeten beginnen.

Naarmate AI-capaciteiten centraler worden in softwareapplicaties, wordt een standaard integratieprotocol minder optioneel en meer essentieel.

De integratiechaos lost zichzelf niet op. MCP is een stap om het beheersbaar te maken.

Benieuwd naar onze andere AI-projecten en inzichten?